| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- CS231n

- VIT

- Fast RCNN

- YAI 8기

- 강화학습

- Faster RCNN

- YAI 10기

- CS224N

- nerf

- cv

- 컴퓨터비전

- cl

- 연세대학교 인공지능학회

- GAN #StyleCLIP #YAI 11기 #연세대학교 인공지능학회

- 3D

- NLP

- 컴퓨터 비전

- GaN

- YAI 9기

- NLP #자연어 처리 #CS224N #연세대학교 인공지능학회

- CNN

- Perception 강의

- transformer

- PytorchZeroToAll

- 자연어처리

- YAI

- Googlenet

- YAI 11기

- rl

- RCNN

- Today

- Total

목록분류 전체보기 (57)

연세대 인공지능학회 YAI

[논문 리뷰] GoogLeNet : Going deeper with convolutions

[논문 리뷰] GoogLeNet : Going deeper with convolutions

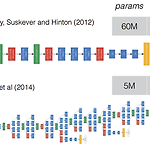

YAI 11기 최가윤님이 작성한 글입니다. [GoogLeNet] Going deeper with convolutions (2015 CVPR) Reference https://arxiv.org/pdf/1409.4842.pdf https://en.wikipedia.org/wiki/Gabor_filter [GoogLeNet (Going deeper with convolutions) 논문 리뷰]https://phil-baek.tistory.com/entry/3-GoogLeNet-Going-deeper-with-convolutions-%EB%85%BC%EB%AC%B8-%EB%A6%AC%EB%B7%B0 Abstract Improved utilization of the computing resources inside..

[논문 리뷰] NeRF : Representing scenes as Neural Radiance Fields for view synthesis

[논문 리뷰] NeRF : Representing scenes as Neural Radiance Fields for view synthesis

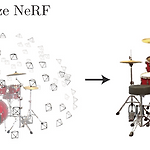

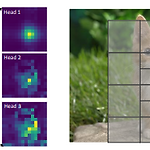

YAI 9기 박준영님이 나의야이아카데미아팀에서 작성한 글입니다. NeRF : Representing Scene as Neural Radiance Fields for View Synthesis [Mildenhall, Ben, et al. "Nerf: Representing scenes as neural radiance fields for view synthesis." Communications of the ACM 65.1 (2021): 99-106.](https://dl.acm.org/doi/abs/10.1145/3503250) Abstract 이 논문은 input으로 한정된 수의 3D scene을 획득, 이를 활용하여 continous volumetric scene function에 입각한 여러 방향에서..

[CS224N] Language Modeling with LSTM and GRU

[CS224N] Language Modeling with LSTM and GRU

YAI 10기 김강현님이 자연어강의팀에서 작성한 글입니다 1. Language Modeling Language modeling이란, 다음 단어로 어떤 단어가 오는지 예측하는 task이다. 그리고 이러한 task를 수행하는 system을 가지고, Language Model이라고 한다. 2. N-gram Language Model 이 방법은, 딥러닝을 도입하기 전에 Language model을 학습시키기 위해 사용했던 방법이다. N-gram이란, N개의 연속된 단어이다. 다음에 어떤 단어가 올 확률을 구하기 위해, 우선 Markov Assumption을 한다: 이는, 다음 단어는 직전 N-1개의 단어에만 영향을 받는다는 의미이다. 즉, 그보다 더 이전 단어에는 영향을 받지 않는다는 의미이다. 만약 4-gra..

[논문 리뷰] Do Transformers Really Perform Badly for Graph Representation?

[논문 리뷰] Do Transformers Really Perform Badly for Graph Representation?

Do Transformers Really Perform Badly for Graph Representation? Github: https://github.com/Microsoft/Graphormer Paper: https://openreview.net/forum?id=OeWooOxFwDa Abstract Graph representation learning에서 Transformer가 좋은 성능을 보이는가? Graphormer standard transformer architecture 많은 graph representation learning task에서 좋은 성능을 보임 especially on the recent OGB Large-Scale Challenge Key Insight graph를 모델링하..

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

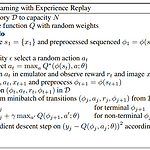

YAI 9기 박찬혁님이 논문구현팀에서 작성한 글입니다. 논문 Playing Atari with Deep Reinforcement Learning Playing Atari with Deep Reinforcement Learning 이번 논문에서는 강화학습을 위한 첫번째 딥러닝 모델인 DQN을 소개한다. 기존의 강화학습과 DNN을 결합시키기에는 몇가지 문제점이 있었다. 보통의 딥러닝 지도학습 task들은 라벨링 된 데이터들이 있었지만 강화학습에서는 이런 데이터들이 거의 없으며 노이즈가 많고 딜레이가 있는 reward를 통해 학습을 진행시켜야한다. 또한, 기존 딥러닝은 데이터간의 연관 관계가 없는 독립 관계라고 가정하고 진행하지만 강화학습의 경우 각 state들이 큰 연관성이 있다. 이 어려움들을 해결하고 강..

[CS224N] Language Model, Analysis, Future of NLP

[CS224N] Language Model, Analysis, Future of NLP

CS224N Lecture 15~18 * 10기 김준완님이 자연어 강의 팀에서 작성하신 리뷰입니다. Language Model Language Model은 Masked LM과, Standard LM 두가지로 나눌 수 있는데, 전자는 BERT류의 Deonising Auto Encoding이고, 후자는 기존의 조건부 확률 기반으로 다음에 올 단어를 예측하는 Auto Regressive 한 모델이다. 이런 예측된 값들은 make sense하지만 항상 factually correct하진 않다. 그 이유는 unseen facts, rare facts, model sensitivity때문이라고 할 수 있다. 여기서 sensitivity는 문맥상 같은의미의 문장이라도 모델은 사용된 단어가 다르면 다른 문장으로 인식할..

[논문 리뷰] Focal Self-attention for Local-Global Interactions in Vision Transformers

[논문 리뷰] Focal Self-attention for Local-Global Interactions in Vision Transformers

YAI 9기 김석님이 비전논문팀에서 작성한 글입니다. Focal Self-attention for Local-Global Interactions in Vision Transformers 0. Abstract 목적 Self attention을 통한 짧은 것에서부터 긴 단위까지 visual dependency를 모두 capture할 수 있도록 설계하면서도 quadratic computational overhead로 인한 resolution이 높은 task에 관해서 어려운 상황도 극복할 수 있어야 함 Method SoTA model의 경우 coarse-grain이나 fine-grained local attention을 적용하여 computational & memory cost와 성능을 개선하는 방식을 채택함 ..

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

Playing Atari with Deep Reinforcement Learning https://arxiv.org/abs/1312.5602 *YAI 10기 최서연 님이 작성한 글입니다. 1. Introduction 기존의 RL algorithm들은 모두 직접 사람이 만든 linear value function이나 policy representation들을 사용했었다. 하지만 비전이나 자연어같은 분야들에서 neural network들을 사용한 알고리즘이 굉장히 성공을 거두며 RL에도 비슷한 종류의 net을 사용할 수 있는 지가 논의의 중심이 되었다. Reinforcement Learning에는 항상 풀지 못하는 숙제들이 있다. Sparse & Delayed Rewards input과 target값이 바로..