| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- RCNN

- GaN

- cl

- NLP

- 강화학습

- YAI 8기

- 컴퓨터비전

- VIT

- YAI 10기

- cv

- CS231n

- GAN #StyleCLIP #YAI 11기 #연세대학교 인공지능학회

- YAI 11기

- rl

- 자연어처리

- YAI 9기

- Googlenet

- 3D

- CNN

- PytorchZeroToAll

- transformer

- CS224N

- Fast RCNN

- YAI

- Faster RCNN

- nerf

- 컴퓨터 비전

- NLP #자연어 처리 #CS224N #연세대학교 인공지능학회

- 연세대학교 인공지능학회

- Perception 강의

- Today

- Total

목록CNN (11)

연세대 인공지능학회 YAI

[논문 리뷰] Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation

[논문 리뷰] Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation

Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation https://arxiv.org/abs/1809.07454 Conv-TasNet: Surpassing Ideal Time-Frequency Magnitude Masking for Speech Separation Single-channel, speaker-independent speech separation methods have recently seen great progress. However, the accuracy, latency, and computational cost of such methods remain insufficient. The ma..

[논문 리뷰] Going Deeper with Convolutions

[논문 리뷰] Going Deeper with Convolutions

Going Deeper with Convolutions YAI 9기 김석님이 비전논문기초팀에서 작성한 글입니다. 0. Abstract 목적 → Network 내에서 compute가 진행될 시 소모되는 자원의 효율성을 높이기 위함 Method Compute 할 양을 늘어나지 않는 상태에서 depth와 width를 늘릴 수 있는 디자인 (codenamed Inception) Optimization 방법 → Hebbian principle에 근거한 multi-scale processing 사용 GoogLeNet Proposal Classification과 detection 목적으로 설계된 22 layer deep network 1. Backgrounds Object detection에서 사용한 방법 → Mod..

[논문 리뷰] Zero-Shot Learning Through Cross-Modal Transfer

[논문 리뷰] Zero-Shot Learning Through Cross-Modal Transfer

Zero-Shot Learning Through Cross-Modal Transfer Socher, Richard, et al. "Zero-shot learning through cross-modal transfer." Advances in neural information processing systems 26 (2013). * YAI 9기 박준영님이 Multimodal팀에서 작성한 글입니다. 논문 소개 Multimodal 연구에 있어 zero-shot learning에 대한 가능성을 연구한 논문이다. 사실상 성능이 그리 뛰어나지도 않고 zero-shot이 가능한 class에 대해서도 제약조건이 걸리지만, 단순히 image feature를 word vector, language manifold로 옮겨,..

[프로젝트 : CV] 다이아몬드 가격 예측

[프로젝트 : CV] 다이아몬드 가격 예측

다이아몬드 가격 예측 ** YAI 9기 석진혁님이 토이 프로젝트 진행 후 작성한 글입니다. Project Review 토이 프로젝트를 진행하며 느낀점과 시도한 것, 추가로 시도해 볼만한 다른 기법에 대해 적어보려합니다. 1) 프로젝트를 시작하기 전에, 해야 할 task를 명확하게 선정하자. 저희 조는 다이아몬드의 가격을 예측하는 프로젝트를 진행했습니다. 캐글에서 보석에 해당하는 ID와 weight, cut, shape 등 다양한 feature와 price(정답)를 담은 csv파일과 각 id에 해당하는 다이아몬드의 이미지를 받았습니다. 프로젝트를 시작할 때, 저희 조는 price에 대한 distribution이나 feature간의 상관관계 등의 데이터 분석을 하지 않고 무작정 모델을 만들고 선정한 metr..

[논문 리뷰] Mask R-CNN

[논문 리뷰] Mask R-CNN

Mask R-CNN ** YAI 9기 조용기님이 비전논문심화팀에서 작성한 글입니다. 1. Introduction 비전 분야에서 객체 감지와 시멘틱 세그멘테이션은 단기간에 빠르게 성장했다. 이러한 발전은 대부분 Fast/Faster R-CNN과 FCN같은 강력한 기준 시스템에 의해 이루어졌다. 이 시스템들은 개념이 직관적이며, 유연성과 강건성(robustness)을 가질 뿐만 아니라 빠른 훈련 및 추론이 가능하다. 이 논문의 목표는 인스턴스 세그멘테이션에 대해 이와 비슷한 수준의 프레임워크를 개발하는 것이다. 1-1. Instance Segmentation 인스턴스 세그멘테이션은 이미지 내 모든 객체의 올바른 탐지와 각 인스턴스에 대한 정확한 분할이 동시에 이루어져야 하는 도전적인 작업이다. 따라서 다음의..

[논문 리뷰] Retina Net : Focal loss

[논문 리뷰] Retina Net : Focal loss

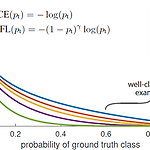

FPN + RetinaNet (Focal Loss) - (2) ** YAI 9기 조용기님이 비전 논문 심화팀에서 작성한 논문입니다. RetinaNet (Focal Loss) Papers with Code - RetinaNet Explained 1. Introduction 2020년 전까지의 object detecton milestones. 출처 : Murthy, C.B et al., Investigations of Object Detection in Images/Videos Using Various Deep Learning Techniques and Embedded Platforms—A Comprehensive Review. Applied Sciences. 2020. 당시의 SOTA object dete..

[논문 리뷰] FPN : Feature Pyramid Network

[논문 리뷰] FPN : Feature Pyramid Network

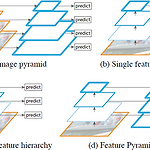

FPN + RetinaNet (Focal Loss) - (1) **YAI 9기 조용기님이 비전 논문 심화팀에서 작성한 글입니다. FPN Papers with Code - FPN Explained 1. Introduction Figure 1. (a) Using an image pyramid to build a feature pyramid. Features are computed on each of the image scales independently, which is slow. (b) Recent detection systems have opted to use only single scale features for faster detection. (c) An alternative is to reuse t..

[논문 리뷰] R-CNN / Fast R-CNN / Faster R-CNN (3)

[논문 리뷰] R-CNN / Fast R-CNN / Faster R-CNN (3)

R-CNN + Fast R-CNN + Faster R-CNN (3) ** YAI 9기 조용기님이 비전 논문심화팀에서 작성한 글입니다. Faster R-CNN Papers with Code - Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks 1 Introduction 이 논문이 쓰인 시점에 탐지 신경망 시스템에 존재하는 병목은 region proposal이었다. Selective Search는 CPU에서 연산되어, Fast R-CNN의 탐지 신경망에 비해 매우 느리다. EdgeBoxes는 proposal의 품질과 속도 사이 최상의 균형을 이루었지만 여전히 탐지 신경망만큼의 실행 시간을 필요로 한다. CNN이 GPU..