| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- CNN

- transformer

- CS224N

- cv

- NLP

- YAI 11기

- 강화학습

- RCNN

- rl

- CS231n

- cl

- YAI 8기

- 컴퓨터비전

- 3D

- VIT

- GaN

- 컴퓨터 비전

- YAI

- Fast RCNN

- GAN #StyleCLIP #YAI 11기 #연세대학교 인공지능학회

- Googlenet

- YAI 9기

- NLP #자연어 처리 #CS224N #연세대학교 인공지능학회

- Perception 강의

- nerf

- PytorchZeroToAll

- Faster RCNN

- 연세대학교 인공지능학회

- 자연어처리

- YAI 10기

- Today

- Total

목록CS224N (4)

연세대 인공지능학회 YAI

[CS224n] T5 and Large Language Models

[CS224n] T5 and Large Language Models

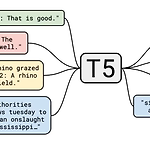

Lecture-14: T5 and Large Language Models ** YAI 9기 전은지님이 자연어강의팀에서 작성한 글입니다. T5 Ideas Which transfer learning methods work best, and what happens when we scale them up? → T5 What about non-English pre-trained models? → modify T5 for multilingual model How much knowledge does the model learn during pre-training? Does the model memorize data during pre-training? Which Transformer modifications work..

[CS224n] Subword Modeling & Pretraining

[CS224n] Subword Modeling & Pretraining

Subword Modeling & Pretraining ** YAI 9기 전은지님이 자연어강의팀에서 작성한 글입니다. 1. Introduction 언어 모델링에서 중요한 부분 중 하나인 단어를 어떻게 표현할 것인가를 살펴보겠습니다. 만약 단어의 개수가 유한하다는 가정, 즉 finite vocabulary assumptions를 기반으로 할 경우에는 단어의 변환, 오타, 새로운 단어 등이 모두 unknown words로 동일하게 매핑되게 됩니다. 따라서 이러한 word structure 혹은 morphology를 다루는 방식이 필요하게 됩니다. 한편, 사전 학습된 대규모의 모델은 자연어 처리에 있어서 거의 표준이 되었고, 그 성능도 매우 뛰어납니다. 이러한 방법론에 대해서도 다뤄보겠습니다. 2. Subwo..

[CS224n] 어텐션 (Attention)

[CS224n] 어텐션 (Attention)

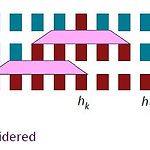

어텐션 (Attention) ** YAI 9기 전은지님이 자연어강의팀에서 작성한 글입니다. 1. Introduction 앞선 글에서 설명드렸던 Seq2Seq의 경우 하나의 hidden state가 모든 source text의 정보를 포함하고 있습니다. 이 때문에 sentimental analysis와 같은 단순한 태스크에서는 성능이 괜찮지만, translation과 같은 복잡한 태스크에서는 information bottleneck이 발생할 수 있습니다. 이 문제를 해결하기 위해 attention 모델이 제안되었습니다. Attention은 decoder의 각 step에서 encoder와 direct connection을 활용하여 source sentence의 특정 부분에 집중합니다. 사람이 실제로 번역을 ..

[CS224n] 기계 번역 (Machine Translation)

[CS224n] 기계 번역 (Machine Translation)

기계 번역 (Machine Translation) ** YAI 9기 전은지님이 자연어강의팀에서 작성한 글입니다. 1. Introduction Machine translation은 어떤 한 언어의 $x$라는 문장을 또다른 언어의 $y$라는 문장으로 번역하는 태스크를 의미합니다. 이때, $x$의 언어를 source language라고 하고, $y$의 언어를 target language라고 부릅니다. 과거에는 rule-based와 dictionary lookup table 등의 방식을 이용했지만, 문법(grammar)이나 의미론(semantic) 등의 이유로 인해서 정보를 잘 전달하지 못했다는 한계가 존재합니다. 이러한 기계 번역의 역사를 살펴보면 아래와 같습니다. 2. Statistical MT (SMT) ..