| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- transformer

- YAI

- CNN

- Googlenet

- RCNN

- cv

- 3D

- 컴퓨터비전

- Perception 강의

- NLP #자연어 처리 #CS224N #연세대학교 인공지능학회

- 컴퓨터 비전

- YAI 8기

- 자연어처리

- GaN

- 연세대학교 인공지능학회

- CS224N

- Fast RCNN

- PytorchZeroToAll

- NLP

- Faster RCNN

- YAI 10기

- GAN #StyleCLIP #YAI 11기 #연세대학교 인공지능학회

- nerf

- YAI 9기

- cl

- YAI 11기

- VIT

- rl

- 강화학습

- CS231n

- Today

- Total

목록YAI 9기 (33)

연세대 인공지능학회 YAI

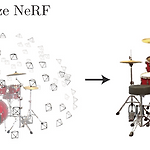

[논문 리뷰] NeRF : Representing scenes as Neural Radiance Fields for view synthesis

[논문 리뷰] NeRF : Representing scenes as Neural Radiance Fields for view synthesis

YAI 9기 박준영님이 나의야이아카데미아팀에서 작성한 글입니다. NeRF : Representing Scene as Neural Radiance Fields for View Synthesis [Mildenhall, Ben, et al. "Nerf: Representing scenes as neural radiance fields for view synthesis." Communications of the ACM 65.1 (2021): 99-106.](https://dl.acm.org/doi/abs/10.1145/3503250) Abstract 이 논문은 input으로 한정된 수의 3D scene을 획득, 이를 활용하여 continous volumetric scene function에 입각한 여러 방향에서..

[논문 리뷰] Do Transformers Really Perform Badly for Graph Representation?

[논문 리뷰] Do Transformers Really Perform Badly for Graph Representation?

Do Transformers Really Perform Badly for Graph Representation? Github: https://github.com/Microsoft/Graphormer Paper: https://openreview.net/forum?id=OeWooOxFwDa Abstract Graph representation learning에서 Transformer가 좋은 성능을 보이는가? Graphormer standard transformer architecture 많은 graph representation learning task에서 좋은 성능을 보임 especially on the recent OGB Large-Scale Challenge Key Insight graph를 모델링하..

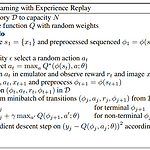

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

[논문 리뷰] Playing Atari with Deep Reinforcement Learning

YAI 9기 박찬혁님이 논문구현팀에서 작성한 글입니다. 논문 Playing Atari with Deep Reinforcement Learning Playing Atari with Deep Reinforcement Learning 이번 논문에서는 강화학습을 위한 첫번째 딥러닝 모델인 DQN을 소개한다. 기존의 강화학습과 DNN을 결합시키기에는 몇가지 문제점이 있었다. 보통의 딥러닝 지도학습 task들은 라벨링 된 데이터들이 있었지만 강화학습에서는 이런 데이터들이 거의 없으며 노이즈가 많고 딜레이가 있는 reward를 통해 학습을 진행시켜야한다. 또한, 기존 딥러닝은 데이터간의 연관 관계가 없는 독립 관계라고 가정하고 진행하지만 강화학습의 경우 각 state들이 큰 연관성이 있다. 이 어려움들을 해결하고 강..

[논문 리뷰] GDumb A Simple Approach that Questions Our Progres

[논문 리뷰] GDumb A Simple Approach that Questions Our Progres

GDumb A Simple Approach that Questions Our Progres * YAI 9기 조용기 님이 작성한 글입니다. 논문소개 GitHub - drimpossible/GDumb: Simplified code for our paper "GDumb: A Simple Approach that Questions Our Progress in Continual Learning". Easily extensible to various settings, datasets and architectures.

[논문 리뷰] ViT / An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

[논문 리뷰] ViT / An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale ** YAI 9기 박찬혁님이 비전논문팀에서 작성한 글입니다. Introduction 현재 Transformer와 같은 Self-attention-based 구조들이 NLP에서 주된 방식이다. 이 방법들은 주로 큰 모델에서 사전학습을 진행 후에 작은 데이터셋으로 Fine tuning하여 사용하는 방식으로 쓰인다. 이 Transformer 방식을 이미지에 바로 적용시키는 것이 이 논문의 목적이다. 이미지를 patch라는 작은 단위로 나누어서 NLP의 token과 같은 방식으로 간단한 imbedding 후에 Transformer에 집어넣는다. 이 방식은 기존 CNN이 이미지에 ..

[논문 리뷰] End-to-End Incremental Learning

[논문 리뷰] End-to-End Incremental Learning

End-to-End Incremental Learning GitHub - fmcp/EndToEndIncrementalLearning: End-to-End Incremental Learning *YAI 9기 조용기님이 Continual Learning 팀에서 작성한 글입니다. 1 Introduction 실제 응용 프로그램을 대상으로 하는 시각적 인식 시스템을 개발할 때 주요 과제 중 하나는 새로운 클래스가 계속해서 학습되는, 즉 분류기를 점진적으로 학습하는 것이다. 예를 들어, 얼굴 인식 시스템은 새로운 사람을 식별하기 위하여 새로운 얼굴을 학습해야 하며, 이러한 task는 이미 학습한 얼굴들을 재학습시킬 필요 없이 해결되어야 한다. 이는 대부분의 사람들에게 사소하지만 (매일 새로운 얼굴들을 인식하므로),..

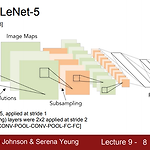

[논문 리뷰] Going Deeper with Convolutions

[논문 리뷰] Going Deeper with Convolutions

Going Deeper with Convolutions YAI 9기 김석님이 비전논문기초팀에서 작성한 글입니다. 0. Abstract 목적 → Network 내에서 compute가 진행될 시 소모되는 자원의 효율성을 높이기 위함 Method Compute 할 양을 늘어나지 않는 상태에서 depth와 width를 늘릴 수 있는 디자인 (codenamed Inception) Optimization 방법 → Hebbian principle에 근거한 multi-scale processing 사용 GoogLeNet Proposal Classification과 detection 목적으로 설계된 22 layer deep network 1. Backgrounds Object detection에서 사용한 방법 → Mod..

[Continual Learning] What is continual learning?

[Continual Learning] What is continual learning?

What is continual learning? * YAI 9기 조현우 님이 작성한 글입니다. Introduction 사람과 다르게 인공지능은 순차적으로 들어오는 데이터를 전부 기억하지 못합니다. 동물을 분류하는 인공지능 모델을 예로 들어보겠습니다. Day 1에는 개의 이미지만 있어서, 이것으로만 학습을 하면 모델은 개를 인식하고 분류할 수 있게 됩니다. 그 다음에 Day 2에 고양이 이미지가 새로 들어와서, 이것으로 새로 학습을 시키면 모델은 고양이를 분류할 수 있게 됩니다. 하지만 고양이로만 학습을 시킨다면 이전에 학습했던 개에 대한 정보는 전부 잃어버리게 될 것입니다. 이처럼 인공지능 모델이 새로운 데이터를 학습할때 기존의 데이터에 대한 정보를 잃어버리는 현상을 Catastrophic forget..