| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- PytorchZeroToAll

- YAI 8기

- Faster RCNN

- Fast RCNN

- VIT

- YAI

- Googlenet

- 컴퓨터 비전

- NLP #자연어 처리 #CS224N #연세대학교 인공지능학회

- CS231n

- transformer

- 강화학습

- CS224N

- GAN #StyleCLIP #YAI 11기 #연세대학교 인공지능학회

- CNN

- NLP

- 컴퓨터비전

- rl

- 자연어처리

- YAI 9기

- YAI 11기

- 연세대학교 인공지능학회

- GaN

- Perception 강의

- YAI 10기

- RCNN

- nerf

- 3D

- cv

- cl

- Today

- Total

목록컴퓨터비전 : CV (24)

연세대 인공지능학회 YAI

[논문 리뷰] Mask R-CNN

[논문 리뷰] Mask R-CNN

Mask R-CNN * YAI 9기 박찬혁님이 비전 논문 심화팀에서 작성한 글입니다. 논문 Mask R-CNN Instance Segmentation 이번 논문인 Mask RCNN은 Instance segmentation을 task로 한다. Deeplab이 목적으로 했던 semantic segmentation은 이미지 속의 객체들에 대한 segmentation과 classification은 진행하지만 서로 다른 객체가 같은 클래스에 속해있다면 구분하지 못했다. 하지만 Instance segmentation은 오른쪽의 사진과 같이 같은 클래스의 다른 객체들을 다 구분할 수 있다. R-CNN R-CNN은 CNN을 object detection에 최초로 적용시킨 모델이다. RCNN은 두가지 stage로 나누어..

Instant Neural Graphics Primitives with Multiresolution Hash Encoding

Instant Neural Graphics Primitives with Multiresolution Hash Encoding

Instant Neural Graphics Primitives with Multiresolution Hash Encoding https://arxiv.org/abs/2201.05989 Instant Neural Graphics Primitives with a Multiresolution Hash Encoding Neural graphics primitives, parameterized by fully connected neural networks, can be costly to train and evaluate. We reduce this cost with a versatile new input encoding that permits the use of a smaller network without sa..

[논문 리뷰] Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation

[논문 리뷰] Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation

Conv-TasNet: Surpassing Ideal Time-Frequency magnitude Masking for Speech Separation https://arxiv.org/abs/1809.07454 Conv-TasNet: Surpassing Ideal Time-Frequency Magnitude Masking for Speech Separation Single-channel, speaker-independent speech separation methods have recently seen great progress. However, the accuracy, latency, and computational cost of such methods remain insufficient. The ma..

[논문 리뷰] StarGAN

[논문 리뷰] StarGAN

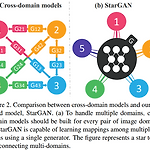

StarGAN: Unified Generative Adversarial Networks for Multi-Domain Image-to-Image Translation YAI 8기 안용준님이 GAN팀에서 리뷰하신 논문입니다. 0. Abstract 현재까지의 연구는 2개 도메인에서의 image2image translation이었다. 2개 이상의 도메인에서 scalability, robustness가 제한적이다. 왜냐하면 모든 도메인 pair마다 모델이 설계되어야 하기 때문이다. 이를 개선하고자, 모든 도메인 간 변환을 한 모델로 가능하게 하는 starGAN을 고안하였다. 이러한 통합 모델은 여러 개의 데이터셋들을 동시에 학습시킬 수 있다. 기존의 모델들보다 생성 이미지 퀄리티가 좋을 뿐만 아니라, 원하는 도..

[논문 리뷰] ViT / An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

[논문 리뷰] ViT / An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale ** YAI 9기 박찬혁님이 비전논문팀에서 작성한 글입니다. Introduction 현재 Transformer와 같은 Self-attention-based 구조들이 NLP에서 주된 방식이다. 이 방법들은 주로 큰 모델에서 사전학습을 진행 후에 작은 데이터셋으로 Fine tuning하여 사용하는 방식으로 쓰인다. 이 Transformer 방식을 이미지에 바로 적용시키는 것이 이 논문의 목적이다. 이미지를 patch라는 작은 단위로 나누어서 NLP의 token과 같은 방식으로 간단한 imbedding 후에 Transformer에 집어넣는다. 이 방식은 기존 CNN이 이미지에 ..

[논문 리뷰] Going Deeper with Convolutions

[논문 리뷰] Going Deeper with Convolutions

Going Deeper with Convolutions YAI 9기 김석님이 비전논문기초팀에서 작성한 글입니다. 0. Abstract 목적 → Network 내에서 compute가 진행될 시 소모되는 자원의 효율성을 높이기 위함 Method Compute 할 양을 늘어나지 않는 상태에서 depth와 width를 늘릴 수 있는 디자인 (codenamed Inception) Optimization 방법 → Hebbian principle에 근거한 multi-scale processing 사용 GoogLeNet Proposal Classification과 detection 목적으로 설계된 22 layer deep network 1. Backgrounds Object detection에서 사용한 방법 → Mod..

[논문 리뷰] NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

[논문 리뷰] NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis **YAI 8기 김현진님이 비전 논문 심화팀에서 작성한 글입니다. European Conference on Computer Vision (ECCV), 2020 (Best Paper Honorable Mention) https://arxiv.org/pdf/2003.08934.pdf 3. Neural Radiance Field Scene Representation 이 논문에서는 연속적인 장면들을 5D 벡터 함수의 형태 (Radiance Field)로 나타낸다. Input은 위치 (x, y, z), 방향 (θ, ϕ) 이고, Radiance와 Radiance의 양을 조절하는 volume..

[논문 리뷰] SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks

[논문 리뷰] SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks

SiamRPN++ ** YAI 9기 조용기님이 비디오논문팀에서 작성한 글입니다. Paper: https://openaccess.thecvf.com/content_CVPR_2019/papers/Li_SiamRPN_Evolution_of_Siamese_Visual_Tracking_With_Very_Deep_Networks_CVPR_2019_paper.pdf 1. Introduction Visual Object Tracking (VOT) 은 최근 수십 년 동안 점점 더 많은 관심을 받아왔으며 현재 매우 활발한 연구가 진행되고 있는 분야이다. Visual surveillanve, Human-Computer Interaction (HCI), 그리고 Augmented Reality (AR)과 같이 다양한 분야에서 ..